米国の非営利団体「Future of Life INSTITUTE」は2024年12月、生成AIの開発主要6社について、安全対策を評価する報告書を発表しました。

その中では、6社すべてに対策の不備があるとし、「AIを人間の制御下に置くための適切な戦略を取っていない」と批判しています。

その内容はどのようなものなのでしょうか。

一方、日本の企業では、生成AIの活用にともない、どのようなリスクが生じると指摘されているのでしょうか。

AIのリスクとセキュリティに関する新たな情報をお届けします。

Column / コラム

HOME > コラム > ものづくり > 生成AI開発大手の安全対策はDランク? 実際の業務におけるリスクについても解説

ものづくり

米国の非営利団体「Future of Life INSTITUTE」は2024年12月、生成AIの開発主要6社について、安全対策を評価する報告書を発表しました。

その中では、6社すべてに対策の不備があるとし、「AIを人間の制御下に置くための適切な戦略を取っていない」と批判しています。

その内容はどのようなものなのでしょうか。

一方、日本の企業では、生成AIの活用にともない、どのようなリスクが生じると指摘されているのでしょうか。

AIのリスクとセキュリティに関する新たな情報をお届けします。

AI機能の急速な向上を目の当たりにして、各企業が関連リスクをどのように報告、評価、軽減しようとしているかに対する関心が高まっています。*1

米国の非営利団体「Future of Life INSTITUTE(フューチャー・オブ・ライフ・インスティテュート)は、AIとそのガバナンスに関する著名な専門家7人からなる独立委員会を招集し、主要な汎用AI開発企業6社の安全対策を評価しました。

その報告書が、2024年12月に発表された「FLI AI Safety Index 2024(AI安全性指標2024)」です。

その内容をみていきましょう。

さまざまなタスクをこなす汎用AIシステムを開発する企業が増えています。

AIの進化は加速し、さまざまな作業で人間と同等かそれ以上の能力を発揮することができます。

AI開発企業は、がんの治療から世界の貧困の撲滅まで、AIは前例のないほどの利益をもたらすと約束しています。

しかし、AIモデルの中には、民主的プロセスの侵食、偏見や誤情報の横行、自律型兵器の軍拡競争など、すでに大きなリスクをもたらしているものもあります。

今後も、さらに悪いことが起こるかもしれません。

軍隊は、危害を与えるように設計された高性能システムによってコントロールを失い、壊滅的な打撃を受ける可能性があります。

企業の利益を最大化することを任務とする高度なAIシステムであっても、予測不能な手段をと

る可能性があります。

利他的なことをするようにプログラムされたAIでさえ、その目標を達成するために、破壊的な方法をとろうとする可能性があります。

現在のところ、私たちはAIシステムがどのように行動するかを知る術がありません。

それで、専門家も一般市民も、新たなAIリスクを管理する必要性が差し迫っているという警戒感をもっています。

しかし、懸念するだけでは十分ではありません。

AIの開発が、単に企業の利益を押し上げるだけではなく、あらゆる場所で人々の生活を向上させることを確実にするための政策が必要です。

そして、この革新的なテクノロジーを極端なリスクから遠ざけ、人類の利益へと導くことができる、強固な規制や有能な機関など、適切なガバナンスが必要なのです。

「FLI AI Safety Index 2024」の目的は、透明性を促進し、強固な安全対策を促進し、改善すべき分野を明らかにして、一般の人々が本物の安全対策と虚偽の主張とを見分けられるようにすることです。*2

汎用AIの技術面およびガバナンス面の第一人者で構成される独立審査委員会が、責任ある行動に関する42の指標によって企業のパフォーマンスを評価し、簡単な説明と改善のための提案を提供しました。

審査にあたった委員の選定は、潜在的な利益相反を減らすため、産業界ではなく学界に焦点を当てています。

この評価は、以下のような資料や調査から得られた、企業情報を含む包括的なエビデンスによって支えられており、収集したエビデンスの全リストが報告書に添付されています。

1)関連する研究論文、政策文書、ニュース記事、業界報告書など、一般に入手可能な資料

2)安全関連の慣行、プロセス、構造に関する、カスタマイズされた業界調査

「FLI AI Safety Index 2024」の企業別評価は以下のとおりです。

なお、評価指標は左から「総合評価」「スコア」「リスク評価」「現在の害」「安全フレームワーク」「必須の安全戦略」「ガバナンスと説明責任」「透明性とコミュニケーション」です。

表1 企業別評価

出所)Future of Life INSTITUTE “FLI AI Safety Index 2024” (ワンページサマリー)(2024年12月11日)p.1

https://futureoflife.org/wp-content/uploads/2024/12/AI-Safety-Index-2024-One-page-11-Dec-24.pdf

表1をみると、各社に対して非常に厳しい評価が与えられたことがわかります。

「FLI AI Safety Index 2024」の調査結果のポイントは以下のようなものでした。

● リスク管理に関する大きな格差: 初期の安全管理体制を確立している企業や、本格的なリスク評価を実施している企業がある一方で、最も基本的な予防措置すら講じていない企業もある。

●Jailbreaks(脱獄: 犯罪などに悪用されないように違法行為に関わるおそれのある質問には原則、回答しないという、AIに設けられた制限を外す手法 *3):すべての主力モデルが、敵対的攻撃に対して脆弱であることが判明した。

●制御の問題:人間の知能に匹敵するか、それを超える能力を持つ人工知能(AGI)を開発するという明確な野望があるにもかかわらず、これらのシステムが人間の制御下にあることを保証するには、各社の現在の戦略は不十分である。

●外部からの監視: 独立した監視がない場合、開発企業が利益主導で安全性に手を抜こうとするインセンティブに抗うことができないことを、審査委員は一貫して強調した。Anthropic社の現在のガバナンス構造とOpenAI社の初期のガバナンス構造は有望であると強調される一方、すべての会社で、リスク評価と安全性フレームワークのコンプライアンスを第三者機関が検証することを、専門家は求めている。

生成AIの開発主要6社すべてにおいて、安全対策が十分にとられていないという、深刻な指摘です。

こうした状況下、日本の企業では生成AIがどの程度利用されているのでしょうか。

総務省の調査結果をみていきましょう。

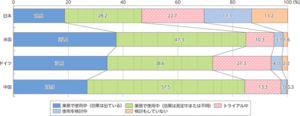

総務省が2023年12月15日から2024年1月15日の間に行ったウェブ調査によると、「メールや議事録、資料作成等の補助」に生成AIを使用していると回答した割合は、日本では46.8%で、米国、ドイツ、中国と比較するとその割合は低くなっています(図1)。*4, *5

図1 業務(メールや議事録、資料作成等の補助)における生成AIの活用状況

出所)総務省「令和6年版 情報通信白書の概要 特集② 進化するデジタルテクノロジーとの共生」

https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/html/nd151120.html

また、生成AIの活用が想定される業務ごとに活用状況を尋ねたところ、海外では顧客対応を含む多くの領域で積極的な活用が始まっている一方で、日本企業は社内向け業務から慎重な導入が進められていることがわかりました。*4

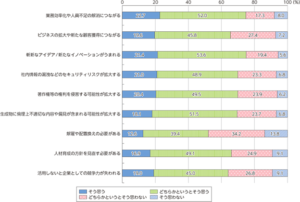

生成AI活用による効果・影響については、74.7%が「業務効率化や人員不足の解消につながると思う」と回答しました(図2)。

図2 生成AI活用による効果・影響

出所)総務省「令和6年版 情報通信白書の概要 特集② 進化するデジタルテクノロジーとの共生」

https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/html/nd151120.html

一方、「社内情報の漏洩などのセキュリティリスクが拡大すると思う」「著作権等の権利を侵害する可能性があると思う」と回答した企業も約7割あり、生成AIのリスクを懸念していることが窺えます。

2024年4月に総務省・経済産業省が策定した「AI事業者ガイドライン(第1.0版)」は、AIによるメリットとリスクについて、従来から存在していたものと生成AIによって顕在化したものとに分けて例示しています。

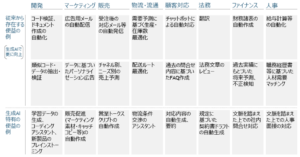

まず、AIによるメリットは以下のようなものです(表2)。*6

表2 AIによるメリット

出所)総務省経済産業省「AI事業者ガイドライン(第1.0版)別添(付属資料)概要」(2024年4月19日)p.6

https://www.meti.go.jp/shingikai/mono_info_service/ai_shakai_jisso/pdf/20240419_4.pdf

この表をみると、生成AIの活用によって多くのメリットがもたらされることがわかります。

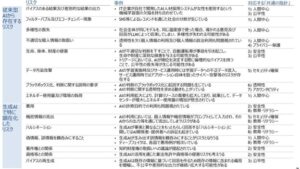

一方、AIによるリスクには、以下のようなものが挙げられています(表3)。

表3 AIによるリスク

出所)総務省経済産業省「AI事業者ガイドライン(第1.0版)別添(付属資料)概要」(2024年4月19日)p.7

https://www.meti.go.jp/shingikai/mono_info_service/ai_shakai_jisso/pdf/20240419_4.pdf

生成AIによって顕在化したリスクとしては、詐欺、機密情報の流出、ハルシネーション(幻覚)などが挙げられています。*7

生成AIは事実に基づかない誤った情報をもっともらしく生成することがあり、これをハルシネーションと呼びます。

ハルシネ―ションは完全に抑制できるものではないため、生成AIを活用する際には、ハルシネーションが起こる可能性を念頭におき、検索を併用するなど、生成AIの出力した答えが正しいかどうかを確認することが望ましいと指摘されています。

また、生成AIの利用に際しては、個人情報や機密情報がプロンプトとして入力され、そのAIからの出力を通じて流出してしまうリスクもあります。

ディープフェイクによる偽画像、偽動画といった偽・誤情報を鵜呑みにしてしまい、情報操作や世論工作に使われるといったリスクもあります。

既存の情報に基づいてAIが生成した回答を鵜呑みにする状況が続くと、既存の情報に含まれる偏見を増幅し、不公平あるいは差別的な出力が継続・拡大する、つまりバイアスを再生成するリスクがあることなども指摘されています。

同ガイドラインでは、これらのリスクは想定に基づく事案も含んでいるため、あくまで一例として認識することを求めたうえで、以下のように述べています。*8

「本リスクの存在を理由として直ちにAIの開発・提供・利用を妨げるものではない。むしろ、当該リスクを認識し、リスクの許容性及び便益とのバランスを検討したうえで、積極的にAIの開発・提供・利用を行うことを通じて、競争力の強化、価値の創出、ひいてはイノベーションに繋げることが期待される。」

このような見解は、上述の「FLI AI Safety Index 2024」と併せて受け止めることが必要ではないでしょうか。

生成AIの機能進化は目覚ましく、業務に活用すれば効率化を図れるため、企業での導入が進みつつあります。

ただし、その裏側ではまだ解決されていないセキュリティ上の課題が多く存在することを認識する必要があります。

生成AIを活用する際には、起こり得るリスクを把握し、専門家の手も借りながら、十分な安全対策をとる必要があります。