製造、マーケティング、医療など、さまざまな領域でAIが活躍するようになりました。自動運転への利活用もそのひとつです。

自動車は人間が運転していても事故を起こしてしまうことがあるものです。

ただ、人間が運転していれば、その責任の所在は明確になります。

ではAIが自動運転をしているときに事故を起こしたら、誰が責任を取るべきでしょうか?

Column / コラム

HOME > コラム > IoT > AIが間違った判断をして事故が起きたら、誰が責任を負う?〜自動運転の議論を中心に

IoT

製造、マーケティング、医療など、さまざまな領域でAIが活躍するようになりました。自動運転への利活用もそのひとつです。

自動車は人間が運転していても事故を起こしてしまうことがあるものです。

ただ、人間が運転していれば、その責任の所在は明確になります。

ではAIが自動運転をしているときに事故を起こしたら、誰が責任を取るべきでしょうか?

さまざまなものを製造・販売するに際して、「製造物責任」という法律を意識する必要があります。

「PL法」とも呼ばれるもので、製造物の欠陥が原因で生命、身体又は財産に損害を被った場合に、被害者が製造業者等に対して損害賠償を求めることができることを規定した法律です*1。

そして、この法律が指す「製造物」とは何なのかについて注目したいと思います。以下のようになっています。

この法律では、製造物を「製造又は加工された動産」と定義しています(本法第2条第1項)。人為的な操作や処理が加えられ、引き渡された動産を対象としており、このため、不動産、電気、ソフトウェア、未加工農林畜水産物などは、この法律の対象にはなりません。

さて、では「自動運転機能を持ったクルマ」はどうなるでしょうか。

クルマという製造物、物理的な本体そのものは法律の対象になります。しかし車を動かすソフトウェアは対象ではありません。

この定義が、課題を複雑にしているという現状があります。

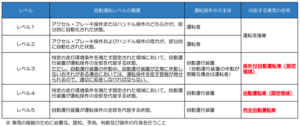

日本国内では自動運転について、「一部自動」から「全自動」までいくつかのレベル分けがあります。

国土交通省は、このように分類しています。

自動運転のレベルと運転操作の主体 (出所:「自動運転車両の呼称」国土交通省資料)

https://www.mlit.go.jp/jidosha/anzen/01asv/report06/file/siryohen_4_jidountenyogo.pdf

「レベル1」「レベル2」のようにアクセル、ブレーキ、ハンドルの操作のみが自動化されているクルマの場合、運転操作の主体は「運転者」つまり人間とされています。この場合は、操作の主体は人間ですから、事故の際には運転している人間が責任を負うべき、という話が成り立つでしょう。

しかし問題はその先です。

レベル3以降になると、一部あるいは全部の運転操作の主体は「自動運行装置」となっています。つまり人間ではなく、装置が運転しているのだから、事故の際は装置が悪いと捉えることもできるのです。

では、AIを用いた完全自動運転が実現した場合、「装置が悪い」と言っても、「装置」とは具体的に何を指すのでしょうか。クルマ本体でしょうか?AIシステムでしょうか?

アメリカですでに、自動運転車による事故が相次いでいます。

2018年にはこのようなことがありました*2。

テスラ製の自動運転車が高速道路の走行車線から外れて中央分離帯に衝突し、乗っていた男性が死亡しました。男性の遺族は自動運転機能に欠陥があったとして、同社を訴えたのです。

死亡した男性はテスラの高度な自動運転機能は「人間が運転する車よりも安全だ」という話を信用していたものの、男性の車両には、当時他のメーカーから広く提供されていたような効果的な衝突防止システムがなかったと、遺族は主張しました。

実際、アメリカの国家運輸安全委員会は調査結果として、事故を起こしたモデルが「システムの限界」によって車線を外れ、障害物を検知するように設計されていなかったと結論づけました。

しかし、最終的に遺族とテスラは和解しています。

国家運輸安全委員会は、死亡した男性がスマートフォンのゲームに気を取られていたため適切な対応を取らなかった、とも指摘しているのです。

テスラは、自動運転機能について「注意を払う必要があること」「完全な自動運転を意味するものではないこと」と主張していたことも、関係していると考えられます。

上記のテスラの事例や経緯は、責任の所在についてまだ理解できる範囲にあると筆者は思っています。

しかし、2023年10月には、「完全無人タクシー」が、他の車がはねた女性をひき、約6メートル引きずって大怪我を負わせるという事故がありました*3。

カリフォルニア州では2023年8月に、2つの企業に24時間営業の無人タクシーの走行を許可しました*4。その直後の出来事です。

この車両を製造したゼネラル・モーターズ傘下のGMクルーズは、米運輸省に提出した届出のなかで、以下のように説明しています。

「衝突検出サブシステムが車両をその場で停止させるのではなく、路肩に寄せた上で停止させようとした可能性がある」

この経緯について、「システムの挙動によりリスクが高まる可能性がある」という指摘を受けています*3。

これらのアメリカの事例では、いずれも一義的にはメーカーが訴訟や説明の対応をしています。しかしニューヨーク州の弁護士でもある中央大学の平野晋教授は、次のような点を懸念しています。

まず、AIほど複雑なソフトウェアでなくても、ソフトウェアの誤作動が事故原因なのか、運転者のアクセル・ブレーキの踏み違えが原因だったのか、ということでさえ、裁判の実務では因果関係の解明が難しいという現実が指摘されています*5。

その上で平野教授は、

AI に責任原因があることが不透明性等の為に立証できないゆえに、製造物責任を課された製造物(端末等)の製造業者等が AI 供給者から求償できない場合には、不公正であるばかりか、真に非難されるべき AI供給者に費用が内部化されずに望ましくない。

(中略)

本来ならば非難(blameworthy)されて賠償責任が課されるべき AI 供給者が製造物責任法上は責任を免れて、製造業者等のみが製造物責任や〈汚名〉までをも課されてしまうという、極めて不公正(unfair)な状態に陥る*5

としています。

例えば一般のクルマで、部品に不備があれば責められるべきは部品メーカーということになります。しかし冒頭にご紹介した通り「ソフトウェア」にはPL法が適用されません。

一義的には「そのシステムを選んで採用したメーカーが悪い」となるのでしょうが、本当にそれで良いのか?と考えた時、筆者は「そうではない」と考えます。

というのは、システムがハッキングされて事故が起きるケースがあるからです。

2015年には実際に、クルマがハッカーによって乗っ取り可能なことが明らかになりました*6。

安全実験として行われたものではありますが、フィアット・クライスラー・オートモービルズ(FCA)製の「ジープ・チェロキー」を走行中にハッキングし、外部から遠隔操作することに成功したのです。

このような場合ですらソフトウェア開発会社は完全に責任を免れることになるのか、という点については今後法整備が必要でしょう。

生成AIが普及しはじめて特に、「責任あるAI」という言葉をよく見るようになりました。

その中で最も重要なのは「透明性」だと筆者は考えています。現在のところ、ChatGPTなどWeb上からも多くの情報を学習してくる生成AIの場合、プロンプトの入力からどのような計算をして回答を導き出しているのか、その全容を把握することはできません。

例えばこれで事故が起きて、人の命や財産に関わる問題となったとき、「AIがやらかしたことだから仕方ない」とは言えません。

AIの演算経路がある程度のブラックボックス性を持っているという事実と、社会がどのように付き合っていくのか、今後の法整備なども含めて見守っていきたいところです。

清水 沙矢香

2002年京都大学理学部卒業後、TBSに主に報道記者として勤務。社会部記者として事件・事故、テクノロジー、経済部記者として各種市場・産業など幅広く取材、その後フリー。

取材経験や各種統計の分析を元に多数メディアに寄稿中。